DALL-E

DALL-E是一个可以通过文本描述生成图像的人工智能程序,於2021年1月5日由OpenAI發布。

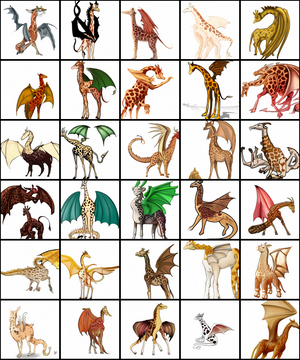

DALL-E生成的一系列长颈鹿与龙的嵌合体图像 | |

| 原作者 | OpenAI |

|---|---|

| 首次发布 | 2021年1月5日 |

| 类型 | Transformer模型 |

| 网站 | openai |

DALL-E通过120亿参数[1]版本的GPT-3 Transformer模型来理解自然语言输入(例如“五边形形状的绿色皮革钱包”或“一只悲伤水豚的等距视图”)并生成相应的图片。[2]它既可以生成现实的对象(例如“带有蓝色草莓图像的彩色玻璃窗”),也能够生成现实中不存在的对象(例如“具有豪猪纹理的立方体”)。[3][4][5]它的名字是2008年動畫電影WALL-E(瓦力)和20世紀西班牙加泰隆尼亞畫家萨尔瓦多·达利(Salvador Dalí)之混成词。[2][1]

自2000年代以来,已有其他许多神经网络有生成逼真图像的能力。[2]而DALL-E的特点在于它能够通过纯文本描述生成这样逼真的图像。[2]

OpenAI尚未发布DALL-E模型的源代码,不过OpenAI在其网站上提供了DALL-E演示,可以查看部分文本描述的输出图像。[1]除了官方版本的DALL-E,另有DALL-E Mini等其他人发布的以少量数据训练的开源替代方案。[6]

历史

编辑DALL-E模型最初于2021年1月5日由OpenAI发布。[7]

2022年4月,OpenAI宣布了新版本的DALL-E 2,声称它可以从文本描述中生成照片般逼真的图像,另外还有一个允许对输出进行简单修改的编辑器。根据OpenAI的公告,该程序仍处于研究阶段,访问权限仅限于小部分测试版用户。该模型有时仍会犯一些人类不会犯的严重错误。[8]OpenAI称DALL-E 2是一个“可以从文本描述中生成原创、逼真的图像和艺术”的模型。[9]

CLIP模型

编辑DALL-E是与CLIP(Contrastive Language-Image Pre-training,对比图文预训练)模型一起开发并向公众发布的。[7]CLIP是一个单独的模型,其作用是理解输出图像并为其打分。[2]DALL-E生成的图像由CLIP模型进行筛选,以呈现最高质量的图像。[7]

架构

编辑GPT模型最初由OpenAI于2018年开发[10],其使用了Transformer架构。第二版的GPT-2于2019年发布。[11]2020年又再次扩大规模发布了拥有1750亿个参数的GPT-3。[1]

DALL-E模型是GPT-3的多模态实现,共拥有120亿个参数[1],使用从网络上收集的文本和图像对进行训练。 [7]它使用零样本学习从描述和提示中生成输出,而无需进一步训练。[12]

DALL-E会根据提示生成多个图像,之后由CLIP模型对这些图像进行排序。[2]CLIP模型使用了超过4亿对图像和文本进行训练。[1]该模型是一个图像识别系统[13],它的训练集是从网络上抓取的图像与描述,而不是诸如ImageNet之类的经过整理的标记图像数据集。[7]CLIP将图像与所有文本相关联。[7]它能够预测哪个文本(从32768个随机采样的文本中选择)最适合图像,使其在之后有能力识别不在其训练集之中的图像中的对象。 [7]

表现

编辑DALL-E能够生成各种风格的图像,从照相写实主义图像[1]到绘画和表情符号。它还可以“操纵和重新排列”图像中的对象。[1]其创作者指出DALL-E的一项能力是在没有明确指示的情况下将设计元素正确放置在新颖的作品中:“例如,当被要求画一个白萝卜擤鼻涕、喝拿铁或骑独轮车时,DALL-E通常能在合理的位置画出手帕、手和脚。” [14]

DALL-E展现了多种能力。《Input》[15]、NBC[16]、《自然》[17]等的报道文章中都提到了DALL-E生成的“穿着芭蕾舞裙遛狗的小白萝卜插图”。 [1][18][19]而它生成的“鳄梨形状的扶手椅”也同样受到关注。[7][20]另一方面,DALL-E还展现出了足以解决瑞文氏标准推理测验(通常用于测量人类智力的视觉测试)的视觉推理技能。 [21]

另外透過增加API提示,可以生成符合特定用途或風格的圖片,用以中性化或達成特殊目的。例如文字與圖片相互配合的語言遲緩治療工具[22],因為對象多為學齡前幼兒,所以必須將圖片濾除太過成人導向的部分。。

剑桥大学机器学习教授尼尔·劳伦斯(Neil Lawrence)认为DALL-E这类模型有能力存储关于我们这个世界的信息,并以人类认为非常自然的方式进行推广。佐治亚理工学院交互计算学院副教授马克·里德尔(Mark Riedl)则认为DALL-E的演示结果表明它能够协调地融合概念,这是人类创造力的关键要素,同时他指出DALL-E绘制的插图比过去几年其他的Text2Image(由文本生成图像)系统要出色许多。[23]

DALL-E模型在没有特定提示的情况下也能够推断合适细节的能力也受到了关注。技术博客ExtremeTech注意到,DALL-E绘制的“穿着圣诞毛衣的企鹅”不仅会生成企鹅穿着毛衣的图像,而且还会生成与主题相关的圣诞老人帽。[24]另一个技术博客Engadget则注意到模型生成的“一幅一只狐狸冬天坐在田野里的画”中出现了适当放置的阴影。[12]此外,DALL-E展示了对视觉和设计趋势的广泛理解。例如,DALL-E可以绘制指定年代的手机或吸尘器的照片,它了解这些物体的形态是如何随时间改变的。[24][12]

不过有时模型也会出现错误。比如DALL-E 2就无法区分“一本黄色的书与一个红色的花瓶”与“一本红色的书与一个黄色的花瓶”这两个描述,也无法区分“正在咖啡拉花的熊猫”与“熊猫图案的咖啡拉花”。[25]

参见

编辑参考文献

编辑- ^ 1.0 1.1 1.2 1.3 1.4 1.5 1.6 1.7 1.8 Johnson, Khari. OpenAI debuts DALL-E for generating images from text. VentureBeat. 2021-01-05 [2021-01-05]. (原始内容存档于2021-01-05).

- ^ 2.0 2.1 2.2 2.3 2.4 2.5 Coldewey, Devin. OpenAI's DALL-E creates plausible images of literally anything you ask it to. 2021-01-05 [2021-01-05]. (原始内容存档于2021-01-06).

- ^ Grossman, Gary. OpenAI's text-to-image engine, DALL-E, is a powerful visual idea generator. VentureBeat. 2021-01-16 [2021-03-02]. (原始内容存档于2021-02-26).

- ^ Andrei, Mihai. This AI module can create stunning images out of any text input. ZME Science. 2021-01-08 [2021-03-02]. (原始内容存档于2021-01-29).

- ^ Walsh, Bryan. A new AI model draws images from text. Axios. 2021-01-05 [2021-03-02]. (原始内容存档于2021-11-25).

- ^ Dayma, Boris; Patil, Suraj; Cuenca, Pedro; Saifullah, Khalid; Abraham, Tanishq; Lê Khắc, Phúc; Melas, Luke; Ghosh, Ritobrata, DALL·E Mini, 2021 [2021-11-29], doi:10.5281/zenodo.5146400, (原始内容存档于2022-08-05)

- ^ 7.0 7.1 7.2 7.3 7.4 7.5 7.6 7.7 7.8 Heaven, Will Douglas. This avocado armchair could be the future of AI. MIT Technology Review. 2021-01-05 [2021-01-05]. (原始内容存档于2021-01-05).

- ^ KAHN, JEREMY. Move over Photoshop: OpenAI has just revolutionized digital image making. Fortune. 2022-04-06 [2022-04-10]. (原始内容存档于2022-04-10) (英语).

- ^ DALL·E 2. OpenAI. [2022-04-06]. (原始内容存档于2022-04-06) (英语).

- ^ Radford, Alec. Improving Language Understanding by Generative Pre-Training (PDF). OpenAI: 12. 2018-06-11 [2021-01-23]. (原始内容 (PDF)存档于2021-01-26).

- ^ Radford, Alec; Wu, Jeffrey; Child, Rewon; Luan, David; Amodei, Dario; Sutskever, Ilua. Language models are unsupervised multitask learners (PDF) 1 (8). 2019-02-14 [2020-12-19]. (原始内容存档 (PDF)于2021-02-06).

- ^ 12.0 12.1 12.2 Dent, Steve. OpenAI's DALL-E app generates images from just a description. Engadget. 2021-01-06 [2021-03-02]. (原始内容存档于2021-01-27).

- ^ For Its Latest Trick, OpenAI's GPT-3 Generates Images From Text Captions. Synced. 2021-01-05 [2021-03-02]. (原始内容存档于2021-01-06).

- ^ Dunn, Thom. This AI neural network transforms text captions into art, like a jellyfish Pikachu. BoingBoing. 2021-02-10 [2021-03-02]. (原始内容存档于2021-02-22).

- ^ Kasana, Mehreen. This AI turns text into surreal, suggestion-driven art. Input. 2021-01-07 [2021-03-02]. (原始内容存档于2021-01-29).

- ^ Ehrenkranz, Melanie. Here's DALL-E: An algorithm learned to draw anything you tell it. NBC News. 2021-01-27 [2021-03-02]. (原始内容存档于2021-02-20).

- ^ Stove, Emma. Tardigrade circus and a tree of life — January's best science images. Nature. 2021-02-05 [2021-03-02]. (原始内容存档于2021-03-08).

- ^ Knight, Will. This AI Could Go From 'Art' to Steering a Self-Driving Car. Wired. 2021-01-26 [2021-03-02]. (原始内容存档于2021-02-21).

- ^ Metz, Rachel. A radish in a tutu walking a dog? This AI can draw it really well. CNN. 2021-02-02 [2021-03-02]. (原始内容存档于2022-07-16).

- ^ Wakefield, Jane. AI draws dog-walking baby radish in a tutu. British Broadcasting Corporation. 2021-01-06 [2021-03-03]. (原始内容存档于2021-03-02).

- ^ Markowitz, Dale. Here's how OpenAI's magical DALL-E image generator works. TheNextWeb. 2021-01-10 [2021-03-02]. (原始内容存档于2021-02-23).

- ^ 小秋子繪本. 小秋子繪本. 小秋子繪本.

- ^ Shead, Sam. Why everyone is talking about an image generator released by an Elon Musk-backed A.I. lab. CNBC. 2021-01-08 [2021-03-02]. (原始内容存档于2022-07-16).

- ^ 24.0 24.1 Whitwam, Ryan. OpenAI's 'DALL-E' Generates Images From Text Descriptions. ExtremeTech. 2021-01-06 [2021-03-02]. (原始内容存档于2021-01-28).

- ^ Saharia. Photorealistic Text-to-Image Diffusion Models with Deep Language Understanding. arXiv:2205.11487 .